La guerra delle stupidità artificiali

Nella guerra per imporre il proprio sistema di intelligenza artificiale, i protagonisti sono sempre di più. Una lotta che non fa che produrre sistemi sempre più intelligenti. C'è da averne paura?

Tempo stimato per la lettura: 11 minuti

La parola di oggi: LLM, Large Language Model. Un tipo di modello linguistico noto per la sua capacità di raggiungere la comprensione e la generazione del linguaggio general-purpose. Gli LLM acquisiscono queste abilità utilizzando enormi quantità di dati per apprendere miliardi di parametri durante l'addestramento e consumando grandi risorse computazionali durante il loro addestramento e funzionamento. (da Wikipedia)

» PENSIERI FRANCHI: Se Google ti ruba il lavoro

Mi piacerebbe fare un po’ il verso a chi ripropone spesso la famosa formula secondo cui “i/gli [inserisci parola a scelta tra meridionali, immigrati, etc.] ci rubano il lavoro” per introdurre quella che, per gli esperti del settore, sembra una vera emergenza.

Il ladro si chiama Google e il piede di porco si chiama “Google's October 2023 Core Update”, che è in pratica un aggiornamento dell’algoritmo con cui i siti vengono indicizzati all’interno del motore di ricerca. Vi chiederete: “ma cosa c’entra Google col lavoro?”. C’entra c’entra.

Google c’entra col lavoro se scrivi su un sito di notizie; c’entra se vendi online; se la tua ricerca di nuovi clienti si basa su quanto facilmente ti troveranno su Google. C’entra se sei un’azienda manifatturiere che deve aumentare la domanda dei suoi prodotti da parte degli utenti finali. Insomma, non devo dirvi che la gente, quando cercare qualcosa, va su Google, no?

Ecco, se Google decide, da un momento all’altro, di cambiare logica con la quale posiziona i siti (oppure sbaglia, questo tweet parla anche di errori), intere aziende perdono la loro visibilità e non la riconquisteranno mai più. Si può investire nello strumento a pagamento (Google Ads), d’accordo, ma a parte il discorso investimenti (ingenti), il risultato non sarà lo stesso.

In pratica ci stiamo rendendo conto, forse un filino troppo tardi, che siamo completamente alla mercé di un’azienda che, legittimamente, col suo motore di ricerca, fa un po’ quello che vuole. Abbiamo lavorato anni, se non decenni, per migliorare il nostro posizionamento su uno strumento che, dall’oggi al domani, potrebbe dirci che il nostro sito non gli piace più, e così tornare a essere un illustre nessuno.

“Ma perché Google dovrebbe farlo?”. Perché il motore è in continua evoluzione, perché è tutto tranne che perfetto e dunque deve trovare modi sempre nuovi per dimostrare che è ancora la prima fonte di informazioni (corrette?) per tutti. Perché altrimenti la gente si sposta e sapete dove va? Va su TikTok (si, la gente cerca le cose anche su TikTok e sapete una cosa? Le trova), va su ChatGPT o peggio ancora, il vero terrore per qualcuno in Google, va su Bing. Che ora, grazie all’implementazione di GPT, non ti fornisce un elenco di siti che conterranno la risposta (forse), ma ti risponde direttamente.

Ecco perché a Mountain View cominciano a dormire meno sereni ed ecco perché il posizionamento del vostro sito farà sempre più su e giù. E da questo non sarà facile uscirne se pure gli esperti SEO1 non sanno in che direzione andare. Questo perché la soluzione, semplicemente, non c’è. Se non quella di cominciare a studiare strategie che possano fare a meno di Google.

Questo è uno soltanto dei terremoti generati dall’arrivo sul mercato delle intelligenze artificiali. Ed è proprio di questo che parleremo oggi, di intelligenze (o stupidità) artificiali.

Buona lettura.

Franco A.

» LA GUERRA TECNOLOGICA TRA I GIGANTI DELL’IA

La guerra che molte aziende tech hanno combattuto, ha visto nel tempo alternarsi diversi campi di battaglia. Prima sui computer e sui sistemi operativi, poi sui dispositivi mobili (smartphone e altro), per poi spostarsi su internet, sui dati che le piattaforme sono capaci di raccogliere per profilarci e quindi vendere pubblicità. Oggi, però, i giganti si stanno sfidando su un campo completamente nuovo: l’intelligenza artificiale.

Quando utilizziamo questo termine, lo facciamo per semplificare un enorme numero di nomi e terminologie tecniche. Non esiste “l’intelligenza artificiale”, esiste invece una serie di tecniche, strumenti e architetture per portare la macchina a darci un certo tipo di risultato. Esiste il Machine Learning, il Deep Learning, le Reti Neurali e molte altre architetture che tentano, in modo o nell’altro, di imitare alcuni aspetti dell’approccio umano alle informazioni. A come le raccogliamo, le analizziamo e infine a come le utilizziamo.

Quando uscì ChatGPT, che fu la prima vera implementazione pratica, aperta a tutti, di un modello di linguaggio evoluto, ho letto articoli di testate importanti gridare alla fine dell’umanità. Una reazione abbastanza prevedibile, perché conseguenza diretta e spontanea di qualcosa che non si conosce.

Ciò che non si conosce fa sempre paura e se nell’antichità un temporale, per l’uomo che non aveva ancora trovato una spiegazione scientifica, poteva rappresentare qualcosa di più di un fenomeno atmosferico (con tutti gli annessi e connessi religiosi e teologici), oggi una macchina con la quale parlare come un essere umano (in alcuni casi anche meglio) fa intravedere un futuro oscuro, popolato da robot antropomorfi fatti di acciaio, con le pupille rosse, che si aggirano armati di fucile a canne mozze cercando di uccidere Sarah Connor.

Questo succede perché, come sempre, non conosciamo ancora la materia di cui parliamo. Vediamo delle immagini incredibili generate da una macchina, testi scritti in un linguaggio perfetto, addirittura musiche o video con protagoniste delle persone che non hanno mai fatto quella cosa che stiamo vedendo e, logicamente, ci preoccupiamo. E facciamo bene a farlo, ci mancherebbe, ma quello a cui stiamo assistendo non è né una magia, né l’inizio del futuro in cui le macchine ci domineranno. O meglio, magari si, ma non come diretta conseguenza di quello che stiamo vedendo oggi. Mancano ancora qualche centinaio di salti tecnologici, volendo fare un’approssimazione.

Come funzionano le intelligenze artificiali?

Una domanda così non meriterebbe una risposta, perché è troppo approssimativa. Quello che ho voluto approfondire è il funzionamento degli LLM, ovvero dei Large Language Model (oppure gli NLP, Natural Language Processing, insomma avete capito), che poi sono quegli strumenti che vi permettono di chiacchierare amabilmente con una macchina pensando che sia talmente intelligente da darvi la risposta che vi darebbe il vostro migliore amico.

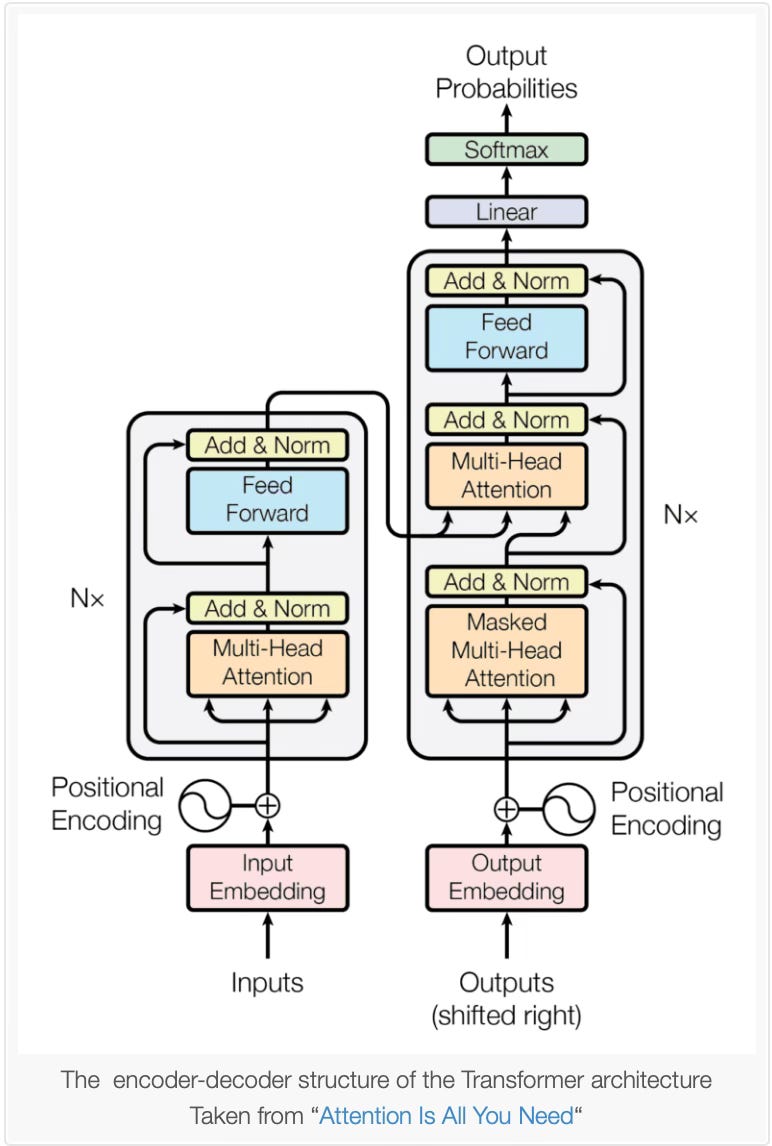

Sotto queste tecnologie incredibili, c’è un’architettura chiamata Transformer, che venne presentata al mondo con questo paper redatto da diversi ricercatori di Google e dell’Università di Toronto nel 2017.

Ve la faccio molto semplice, mi perdoneranno gli eventuali lettori esperti della materia se non sarò tecnicamente perfetto (e anche se non mi ci avvicinerò nemmeno): l’architettura Transformer (altro nome altisonante, che burloni che sono questi ricercatori) permette di arrivare, secondo un calcolo probabilistico, a mettere insieme una parola corretta dopo l’altra. Ed è tutto qui, davvero. Tra poco vi spiegherò come. Tra il dire e il fare di mezzo c’è un sacco di scienza, lo immaginerete, ma nel frattempo vi spiego un altro mistero.

Il mistero delle macchine che mentono

Per tanto tempo mi sono chiesto come mai questi modelli preferissero inventare una stupidaggine piuttosto che rispondere “non lo so”. Per tanto tempo, questo mi ha fatto davvero paura: la macchina non conosce l’ansia, perché dovrebbe rispondermi inventandosi una frottola piuttosto che dirmi “non lo so”? Non ci hanno sempre detto che il computer ragiona in maniera binaria e quindi se un’informazione non ce l’ha, non ce l’ha e basta?

Ecco, ritorniamo al calcolo probabilistico. Perché lo scopo di questi modelli non è quello di cercare una risposta e dartela, ma darti la risposta che è, a livello probabilistico, più corretta. È una logica completamente diversa da quella che conosciamo, ecco perché è importante sapere cosa c’è alla base di tutti questi strumenti, prima di gridare alla fine dell’umanità.

Quando ChatGPT, Google Bard o il più recente Grok (quello di xAI, la società indovinate un po’ di chi? Si, Elon Musk) vi suggerisce come uccidere il vicino o come porre fine all’umanità, non si sta lasciando sfuggire un piano sul quale sta segretamente lavorando, ma vi sta rispondendo mettendo insieme le parole che rispondono alla vostra domanda, secondo un calcolo probabilistico di quanto quelle parole possano corrispondere a quello che volete sentirvi dire.

Come funziona Transformer e perché imita l’attenzione umana

Ora farò il doppio salto carpiato e cercherò di spiegare, in maniera semplice, come funziona questa complessa architettura.

Il concetto di “attenzione” è stato studiato sull’essere umano per molto tempo. Cos’è l’attenzione? Cos’è la concentrazione? Vi faccio rispondere da qualcuno che ne sa più di me:

In its most generic form, attention could be described as merely an overall level of alertness or ability to engage with surroundings.

Nella sua forma più generica, l'attenzione potrebbe essere descritta semplicemente come un livello generale di vigilanza o capacità di interagire con l'ambiente circostante.

– Attention in Psychology, Neuroscience, and Machine Learning, 2020.

Poi c’è l’attenzione visiva. Quando a un soggetto vengono proposte immagini diverse, i movimenti oculari vanno alla ricerca delle parti dell’immagine più importanti, ovvero parti caratterizzate da attributi quali il contrasto, i bordi, gli angoli, i movimenti. Il cervello dell’uomo processa queste caratteristiche in diversi stadi neurali.

I neuroni nelle prime fasi sono sintonizzati su semplici attributi visivi come il contrasto di intensità, l’opposizione dei colori, l'orientamento, la direzione e la velocità del movimento o la disparità stereo su diverse scale spaziali. La sintonizzazione neuronale diventa sempre più specializzata con la progressione dalle aree visive di basso livello a quelle di alto livello, in modo tale che le aree visive di livello superiore includano neuroni che rispondono solo ad angoli o giunzioni, segnali di shape-from-shading o viste di specifici oggetti del mondo reale.

– Computational Modelling of Visual Attention, 2001

Nel campo della Visual Attention sono state fatte due scoperte interessanti: prima di tutto, soggetti diversi tendono ad essere interessati dagli stessi punti salienti. Come se esistesse una sola tecnica di scansione dell’immagine comune all’essere umano.

In secondo luogo, siccome il cervello umano ha una capacità di memoria limitata, la selezione delle informazioni più importanti è fondamentale per utilizzare al meglio le risorse limitate. In pratica, il cervello dell’uomo utilizza l’attenzione per poter selezionare le informazioni più importanti, dando a queste un “peso” maggiore rispetto alle altre.

E questo concetto, quello dell’attenzione, è alla base dell’architettura Transformer. L’attenzione nel machine learning viene utilizzata per selezionare le parti interessanti di un discorso, seguendo questo percorso logico:

Un processo che "legge" i dati grezzi (come le parole di origine in una frase di origine) e li converte in rappresentazioni distribuite, con un vettore di caratteristiche associato a ogni posizione di parola.

Un elenco di vettori di funzionalità che memorizzano l'output del lettore. Questo può essere inteso come una "memoria" contenente una sequenza di fatti, che possono essere recuperati in seguito, non necessariamente nello stesso ordine, senza doverli visitare tutti.

Un processo che "sfrutta" il contenuto della memoria per eseguire in sequenza un'attività, in ogni fase temporale avendo la capacità di attirare l'attenzione sul contenuto di un elemento di memoria (o alcuni, con un peso diverso).

– Page 491, Deep Learning, 2017.

Questo può essere complesso, me ne rendo conto, ma prendete per buono questo: la macchina analizza un testo, comincia ad attribuire un’importanza diversa a ogni singola parola (come se le evidenziasse con un evidenziatore) e poi crea una memoria di fatti in sequenza.

Bisogna pensare poi che questo ciclo viene reiterato più e più volte, a diversi livelli di complessità all’interno dell’architettura Transformer. Tutto questo per arrivare a dare una risposta che sia il più corretta possibile a livello probabilistico.

Ora, seppure detto malissimo, potete capire che se applico questo modello a tonnellate di testi e poi a una fase di verifica assistita (ovvero dove c’è un essere umano che dice alla macchina “questo è giusto” e “questo no”), si arriverà per approssimazioni a una macchina che parla in maniera perfetta. E infatti questi modelli lo fanno. E disegnano anche in maniera (quasi) perfetta. Ma non inventano niente, sanno assemblare benissimo quello che, a livello probabilistico, hanno analizzato.

Tra l’altro, avrete capito indirettamente perché questi sistemi, tutti, chiedono continuamente il vostro feedback. Avrete notato i due tastini con il pollice alzato e quello verso su ogni risposta che vi dà ChatGPT, vero? Ecco, anche voi state contribuendo ad allenare questo sistema, che poi è il motivo per cui ce lo fanno utilizzare gratis, almeno per ora. Ed è il motivo per cui i giganti si stanno facendo la guerra.

Google, OpenAI, Microsoft, xAI. Chi vincerà la guerra?

Arrivati a questo punto possiamo finalmente concentrarci sul titolo e sul perché i giganti del settore tecnologico si stanno sfidando a colpi di IA. Ha iniziato OpenAI con ChatGPT, diventato uno strumento popolassimo ormai tra i professionisti di qualsiasi settore. È arrivata all’inseguimento Google che, come abbiamo visto, era allo studio da anni sul questo tipo di modello. Poi è entrata Microsoft, investendo pesantemente in OpenAI e tentando di assumere anche il suo CEO (un’altra storia che meriterebbe di essere raccontata). Ultimo è arrivato Musk con il suo Glok (non senza aver prima criticato severamente questo tipo di tecnologie… ma l’uomo, si sa, è volubile).

Chi manca all’appello? Già, Meta, che ha già annunciato un suo modello di linguaggio (Llama) a inizio anno e che probabilmente integrerà funzioni generative all’interno dei suoi social (ma anche in Whatsapp) per rendere più semplice e veloce la generazione di immagini, sticker e GIF animate.

Poi c’è Amazon, che da anni offre al mondo enterprise i suoi sistemi di intelligenza artificiale (Machine Learning, Deep Learning, Reti Neurali e quant’altro) e Apple, che di solito è più silenziosa, ma che sappiamo essere all’opera per evolvere il suo assistente vocale Siri e chissà per cos’altro.

Potremmo dire l’intelligenza artificiale è la next big thing nella tecnologia, ma soprattutto nel marketing. Il futuro ce l’ha fatto vedere già Bing, seppure con molti margini di miglioramento. Un futuro in cui chiederemo delle cose al motore di ricerca, il quale però non ci risponderà con fonti esterne, ma direttamente.

Mi ricollego quindi all’editoriale: che fine faranno i siti web quando i motori di ricerca faranno tutto da sé, fornendo direttamente le risposte a tutte le domande? Forse è questa la vera domanda che dobbiamo farci e il futuro di cui bisogna un po’ temere gli esiti. Di macchine che prendono forma e ci inseguono sull’autostrada, invece, non ne vedremo di certo. Almeno per i prossimi anni.

» COSE MOLTO UTILINK 🔗

Gli articoli più interessanti che ho letto in settimana, insieme ai link utili o semplicemente curiosi che ho trovato in giro per internet.

» TikTok ci racconta un’Italia inspettabile

TikTok è una fonte di dati inesauribile. In questo report sul 2023 in Italia, ci mostra quali sono stati gli account più seguiti, le canzoni più ascoltate e gli hashtag più popolari.

Interessante come, nella top 10 degli account con più visualizzazioni, ce ne siano molti che personalmente non avrei potuto immaginare. Tra cui quello di NewMartina, popolarissima giovane campana che cambia i vetri e le cover degli smartphone. La conoscevo già e sapevo che aveva molto seguito, ma da qui ad accumulare quasi mezzo miliardo di visualizzazioni su un solo video, ce ne passa.

» CONSIGLI PER L’ASCOLTO 🎧

Un po’ di auto promozione non fa mai male. Quindi, se ve la siete persa, la scorsa settimana è uscita la nuova puntata, la numero 15, di Insert Coin -Chiacchiere, ovvero lo spinoff del podcast di videogiochi di Massimiliano Di Marco in cui partecipo anche io, in qualità di anziano disturbatore.

» SFAMA LA FOMO!

Cos’è la F.O.M.O.?2

» GTAVI è qui (o almeno il primo trailer)

Con un rocambolesco susseguirsi di eventi, tra cui l’apparizione del trailer piratato tramite un account Twitter e il conseguente anticipo da parte di Rockstar del rilascio del trailer ufficiale, è arrivato finalmente il primo, attesissimo trailer di GTA VI, forse uno dei videogiochi più attesi della storia. Tante sono state le polemiche e tante le chiacchiere. A voi insalatieri io lascio qui soltanto il video, che ognuno si faccia le proprie idee a riguardo.

» Inviare immagini senza compressione tramite Whatsapp, ora si può (anche su iOS)

WhatsApp ha rilasciato un gradito aggiornamento su iOS, permettendo ora non solo di inviare immagini ad alta qualità, ovvero con minore compressione, ma addirittura di inviarle tali e quali come sono. Ovvero di trasferire file dal proprio dispositivo come fossero dei documenti. E infatti la funzionalità prevede proprio di caricare immagini e video come dei documenti. A questo punto, i più maliziosi ne hanno anche ipotizzato un utilizzo non proprio lecito, ma è evidente che nessuno utilizzerà mai WhatsApp in questo modo, giusto?

» Stellantis punta sull’idrogeno per veicoli commerciali e pickup

Per moltissimi esperti del settore la parola “idrogeno”, quando si parla di alimentazione dei autoveicoli, è una parola ormai legata al passato. Eppure Stellantis sembra crederci ancora visto che, insieme a Forvia e Michelin, ha inaugurato il più grande stabilimento europeo di produzione di celle a combustibile, col quale si prevede la produzione di circa 50.000 veicoli l’anno già a partire dal 2026.

Se sei arrivato fino a qui, innanzitutto ti ringrazio.

Non ci siamo presentati: mi chiamo Franco Aquini e da anni scrivo di tecnologia e lavoro nel marketing e nella comunicazione.

Se hai apprezzato la newsletter Insalata Mista ti chiedo un favore: lascia un commento, una recensione, condividi la newsletter e più in generale parlane. Per me sarà la più grande ricompensa, oltre al fatto di sapere che hai gradito quello che ho scritto.

Franco Aquini

SEO è l’acronimo di Search Engine Optimization, e rappresenta l’insieme di tecniche di scrittura e di ottimizzazioni tecniche attraverso cui si cerca di rendere il più appetibile possibile il proprio sito per Google, nella speranza che venga indicizzato e proposto agli utenti quando cercano un argomento per cui vogliamo che il nostro sito venga visualizzato.

La F.O.M.O., un acronimo che sta per Fear Of Missing Out, è la deriva moderna del tam tam dei social network unita all’enorme disponibilità di strumenti di informazione e di intrattenimento. In pratica, è la paura di perdersi qualcosa e di non essere sempre al passo con i tempi. Con questa rubrica rispondiamo a queste paure, riassumendo in breve le notizie più significative della settimana, pescate dal mondo della tecnologia, dell’entertainment e del lifestyle.