Workslop: e se l’AI, invece di aumentarla, affossasse la produttività?

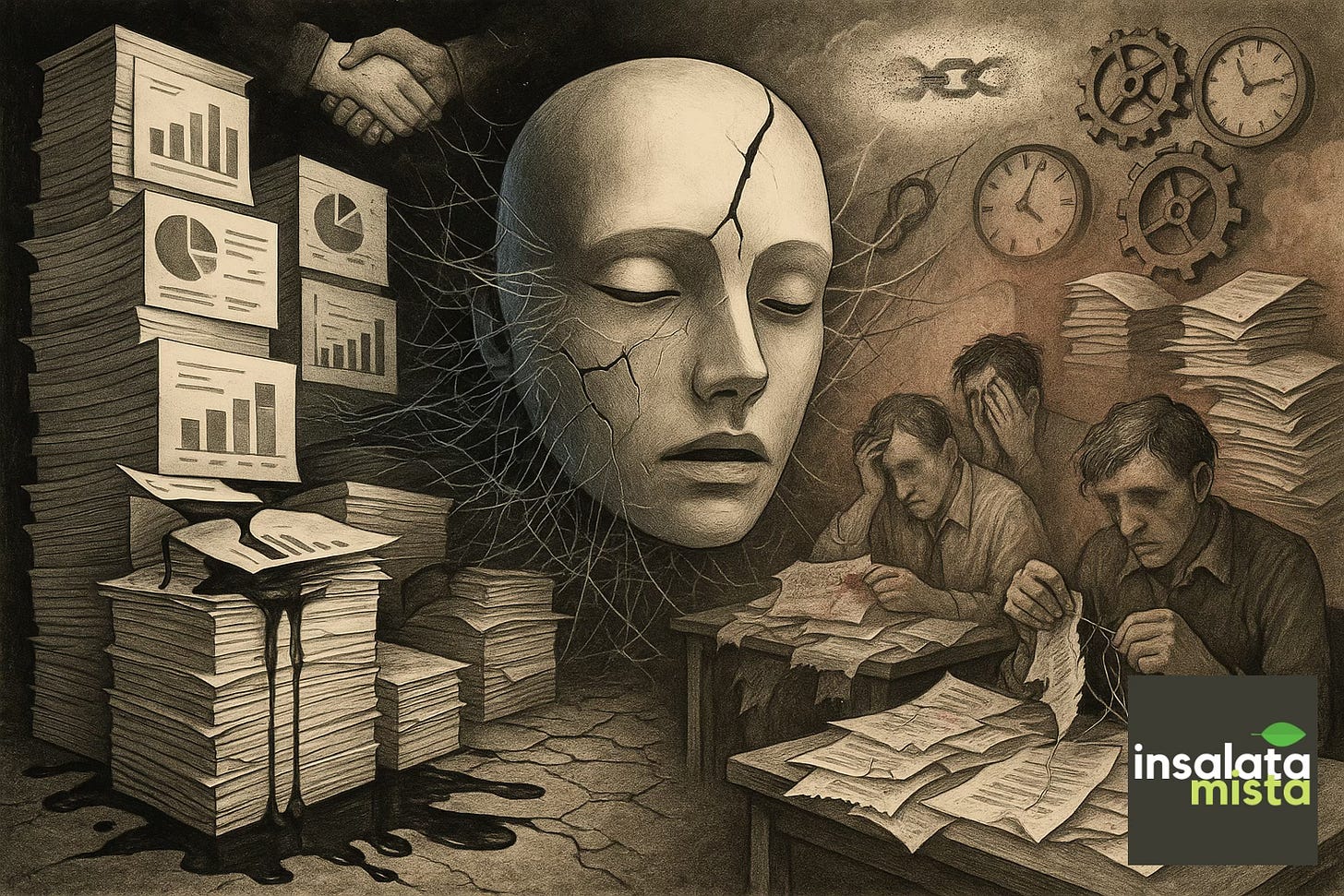

Promessa di produttività o montagna di scartoffie digitali? L’AI può accelerare i processi o rallentarli, a seconda di come viene usata: la differenza la fanno le persone.

Da quando l’AI è entrata con prepotenza nelle nostre vite, da quel novembre 2022, la diffusione in ambito lavorativo e aziendale è stata pressoché immediato e totale. Oggi non c’è ambito professionale o personale che non sia stato intaccato dalle chat intelligenti a cui chiediamo di tutto.

Nella vita personale, tuttavia, è una questione di scelte e l’uso di queste soluzioni è ancora relegato ai più smanettoni o agli studenti che le usano per farsi dare un “aiutino”. Sul lavoro invece è diventata una questione imprescindibile. Perché l’AI fa il lavoro al posto tuo — questo è quello che ci viene detto — e dunque aumenta la produttività.

Il mantra è proprio questo: se non utilizzi l’AI rimarrai indietro perché non sarai al passo con le altre aziende. E questo è inevitabilmente vero, perché abbiamo toccato tutti con mano quanto possa semplificare certi compiti che prima potevano richiedere ore. Quel tempo viene liberato per fare altro e quindi, a parità di numero dipendenti (o di ore lavorate), si produce di più. Che poi è l’esatta formula per calcolare la produttività.

Tutto questo castello teorico potrebbe però franare di fronte a una piccola variabile impazzita nell’equazione sull’utilizzo dell’AI: la capacità di comprendere il compito che si sta svolgendo (il task) e di chiedere all’AI la cosa giusta (il prompt). Se non si è più che abili nel padroneggiare queste due capacità, solo apparentemente banali, tutto crolla e l’AI - anziché utile, indispensabile e volano di crescita della produttività - diventa l’esatto opposto. Diventa una zavorra della produttività, si trasforma in motore di sfiducia tra colleghi, di ingiustizia sociale, di perdita di interesse verso l’uso della tecnologia. Genera quello che negli Stati Uniti hanno già battezzato con una parola ad hoc: workslop.

Il Workslop è quel lavoro generato dall’AI che sembra perfetto ma che invece è completamente da buttare. È quell’output lucido ma vuoto che sembra lavoro, ma in realtà è solo un carico di problemi travestito da efficienza. Ed è ancora più dannoso di un lavoro fatto male, perché più difficile da individuare, nascosto com’è sotto la scorza di un lavoro ben presentato e impacchettato.

Workslop è una relazione che non c’entra il punto, che non risponde alla richiesta, che non entra nei dettagli richiesti, che cita esempi sbagliati, che fraintende completamente lo scopo. Perché è dannosissimo? Perché per essere individuato richiede a un’altra persona di controllare tutto e rileggere completamente il documento. Già questo controllo si mangia l’eventuale efficienza generata dall’AI, ma sono soprattutto gli effetti collaterali a fare i danni veri e propri.

Chi deve occuparsi di controllare questo lavoro perderà fiducia nel collega che l’ha fatto. Magari, oltre che la fiducia, perderà del tutto la stima, perché non sarà difficile capire che si è trattato di un compito non sbagliato, ma condotto con sciatteria. Non un errore, quindi, ma intenzione precisa di fare un lavoro male e scaricarlo sul prossimo anello della catena.

Si logoreranno così i rapporti professionali all’interno dei dipartimenti e degli uffici e infine si genererà quell’ingiustizia sociale data dalla presenza di chi lavora onestamente e con attenzione e chi invece fa il minimo indispensabile per tirare alla fine del turno e poi lasciar cadere la penna.

Che poi è un po’ la storia di tutti i posti lavorativi del mondo, vero. Però con l’AI i furbetti hanno un’arma in più per poter dire «Fatto!» e poi lasciare il “merdone” — mi si passi il termine — al compagno di ufficio o di scrivania. Quello che poi dovrà fare gli straordinari per correggere il lavoro del collega furbo che nel frattempo è andato a giocare a tennis.

Il problema non è l’AI, tutt’altro. È come la si usa, ovvero la solita componente umana. E non è nemmeno detto che sia una questione di capacità, perché una persona potrebbe anche essere estremamente capace ma semplicemente svogliata e pertanto butta lì il primo prompt che gli esce e a posto così, buona la prima. Ecco dunque perché l’AI può essere anche un’arma a doppio taglio, un argomento di cui ha parlato per la prima volta un articolo apparso pochi giorni fa su Harvard Business Review.

La grande promessa: un’AI che lavora per noi

Quando si parla di intelligenza artificiale in azienda, il tono dominante è quello dell’entusiasmo. I numeri che circolano nelle presentazioni dei consulenti e nei report dei grandi istituti sono di quelli che fanno tremare i polsi, soprattutto di chi ricopre un ruolo che potrebbe essere facilmente sostituito da un task affidato a un bot.

McKinsey, ad esempio, stima che l’adozione diffusa della generative AI possa generare fino a 4,4 trilioni di dollari di valore aggiunto all’anno a livello globale, un impatto paragonabile all’intero PIL del Giappone. Il Federal Reserve Bank of St. Louis, in un’analisi del 2025, calcola che gli utenti di AI generativa riescano a risparmiare in media il 5,4% delle ore lavorative, che a livello macro si tradurrebbe in un incremento dell’1,1% della produttività aggregata: non un dettaglio, in economie dove anche uno 0,3% in più viene accolto come un successo.

Il Penn Wharton Budget Model guarda ancora più lontano: nelle sue proiezioni, l’AI potrebbe contribuire a un aumento del PIL mondiale del +1,5% entro il 2035, del +3% entro il 2055 e addirittura del +3,7% entro il 2075.

Non è solo questione di numeri: è questione di approccio al lavoro. È una vera rivoluzione nei processi aziendali a tutti i livelli, persino nella manifattura. Non è un caso se molti economisti e osservatori hanno paragonato l’impatto dell’AI alle grandi rivoluzioni industriali del passato. È, a tutti gli effetti, una nuova rivoluzione industriale.

L’introduzione del motore a vapore nell’Ottocento, l’elettricità alla fine del XIX secolo, l’informatica e Internet nel Novecento: ogni volta una tecnologia di base ha raddoppiato o triplicato la capacità produttiva delle società che l’hanno adottata. L’AI viene raccontata come la prossima tappa di questa linea evolutiva, con la differenza che, diversamente delle precedenti rivoluzioni, non riguarda solo il lavoro manuale o industriale ma direttamente le funzioni cognitive, cioè la parte del lavoro che fino a ieri sembrava intoccabile.

Le aziende lo hanno capito subito. Secondo il Work Trend Index 2024 di Microsoft e LinkedIn, il 75% dei knowledge workers nel mondo utilizza già strumenti di AI almeno una volta alla settimana per scrivere testi, preparare presentazioni o analizzare dati. Tra i manager la percentuale sale al 46%, segno che la pressione all’adozione viene dall’alto, con il doppio obiettivo di sembrare innovativi e di accelerare processi spesso percepiti come lenti. Anche in Italia la corsa è partita: l’Osservatorio Artificial Intelligence del Politecnico di Milano ha registrato che un’azienda su due ha già avviato progetti di sperimentazione, soprattutto nei settori bancario, assicurativo e retail.

La promessa è seducente: liberare tempo prezioso da attività ripetitive e a basso valore aggiunto per permettere ai dipendenti di concentrarsi su compiti più creativi e strategici. Non a caso, l’OCSE inserisce l’AI generativa tra le “General Purpose Technologies”, quelle destinate a ridefinire interi settori così come fecero la stampa o l’elettricità. La narrazione aziendale è chiara: non si tratta più di chiedersi se usare l’AI, ma di quanto velocemente lo si farà. Chi non adotta rischia di restare indietro, chi la integra può correre più veloce.

Eppure, come ogni promessa di modernizzazione radicale, anche questa ha le sue zone d’ombra. Perché dietro i miliardi di dollari e le curve di crescita vertiginose, si nasconde una domanda cruciale: tutta questa produttività esiste davvero, o è in gran parte proiezione?

La realtà quotidiana: il lavoro che si moltiplica

Se i numeri raccontano una storia di crescita inarrestabile, la quotidianità degli uffici offre un’immagine molto diversa. A dare un nome al problema sono stati i ricercatori di BetterUp Labs insieme allo Stanford Social Media Lab, che hanno coniato il termine “workslop”. È un neologismo nato per descrivere quegli output generati dall’AI che, pur apparendo curati e professionali, si rivelano inutili o addirittura dannosi. Una relazione scritta bene ma priva di sostanza, una presentazione elegante che non risponde alla domanda del cliente, una mail lunghissima che mescola concetti imprecisi: in apparenza lavoro ben fatto, in realtà tempo perso.

Il fenomeno non è marginale. Nel sondaggio condotto su 1.150 lavoratori full-time negli Stati Uniti, il 40% ha dichiarato di aver ricevuto almeno un contenuto workslop nell’ultimo mese. E non si tratta di casi isolati: in media, i dipendenti stimano che circa il 15,4% dei documenti ricevuti rientri in questa categoria. L’impatto non è solo psicologico — la frustrazione di dover decifrare materiale confuso — ma anche economico: ogni episodio richiede in media 1 ora e 56 minuti per essere corretto o rifatto da zero. Tradotto in termini monetari, equivale a una “tassa nascosta” di 186 dollari al mese per lavoratore. Su scala aziendale, i conti diventano impressionanti: per un’organizzazione di 10.000 dipendenti, il workslop può costare più di 9 milioni di dollari l’anno in produttività persa.

Ora, qui parliamo soltanto di documenti e la fonte americana dei dati è chiaramente incentrata su un tipo di azienda che in Italia non è molto diffusa. Provate però a proiettare tutto questo su un ambito professionale più tipicamente nazionale come la manifattura. Provate a immaginare quando l’AI arriverà prepotentemente nei CAD con cui gli uffici tecnici progettano i pezzi che poi verranno prodotti da torni CNC, oppure nelle relazioni tecniche che devono essere prodotte per certificare un impianto. Pensate se tutto questo potesse essere generato in pochi minuti con l’AI e con un atteggiamento troppo “leggero” da far lasciar passare risultati non verificati attentamente. Cosa potrebbe succedere? Il passaggio successivo a riscontrare l’errore sarebbe direttamente la linea produttiva, con un danno economico decisamente maggiore delle due ore perse da un dipendente a leggere e correggere una relazione prodotta da un altro.

Questo problema però non colpisce solo settori già fragili, dove si utilizza meno la tecnologia. Tutt’altro: i dati mostrano che l’incidenza maggiore si trova proprio in quelli teoricamente più all’avanguardia, ovvero servizi professionali e tecnologici. In altri termini, dove ci si aspetterebbe un uso raffinato dell’AI, si genera invece la maggiore quantità di “scartoffie digitali”. Le testimonianze raccolte nello studio della HBR sono eloquenti. Un dipendente del settore finanziario racconta di aver perso tempo a decidere se riscrivere un documento da capo, chiedere al collega di rifarlo o “accettare il compromesso”: «È la strada verso una società pigra e mentalmente lenta, dipendente da forze esterne». Un manager del tech descrive invece un’email generata con l’AI come «così confusa da richiedere ore solo per riunire il team e spiegare quello che avrebbe dovuto dire in poche righe».

In queste dinamiche si nasconde l’effetto più subdolo: lo spostamento del carico cognitivo. Mentre l’AI alleggerisce il lavoro di chi genera il contenuto, trasferisce il peso su chi lo riceve. Non è più il lavoratore che scarica lavoro sulla macchina — come è accaduto con l’arrivo di internet o con i software di automazione — ma l’uomo che scarica lavoro su un altro uomo usando la macchina come intermediario. Un cortocircuito che ribalta la promessa iniziale di efficienza e potrebbe arrivare, paradosso dei paradossi, a richiedere più lavoro umano anziché dimezzarlo.

I casi di successo: quando l’AI funziona

Sarebbe però riduttivo raccontare l’AI in azienda solo come una fabbrica di inefficienze. Ci sono esperienze che mostrano il lato opposto della medaglia: quando l’AI è incanalata correttamente, i risultati sono tangibili. Il MIT Sloan School of Management ha condotto un esperimento con un gruppo di consulenti aziendali, dividendoli tra chi poteva utilizzare un modello generativo e chi no. I primi hanno migliorato le loro performance del 38% nei compiti più complessi, con un ulteriore incremento al 42,5% per coloro che avevano ricevuto formazione specifica sull’uso dell’AI. In altre parole, non solo l’AI può accelerare il lavoro, ma la combinazione tra tecnologia e competenza umana amplifica l’effetto.

Un altro esempio arriva dal mondo dello sviluppo software. E in questo contesto, credetemi, l’AI può fare una differenza davvero esagerata. Partiamo con le fonti autorevoli, poi vi darò il mio parere personale, per quello che conta.

GitHub Copilot, che è la versione del repository di codice GitHub con l’aggiunta dell’AI di Microsoft Copilot, testato in contesti bancari come quello di ANZ Bank, ha mostrato che i programmatori che lo utilizzavano producevano codice più velocemente e con meno errori rispetto ai colleghi. In ambiente open source, la ricerca condotta da Stanford e Cornell su oltre 150 progetti ha rilevato un miglioramento qualitativo del 6,5% nei contributi di gruppo quando veniva impiegata l’AI, pur con un costo maggiore in termini di coordinamento tra sviluppatori. Qui emergono due lezioni importanti: l’AI può aumentare la produttività, ma richiede investimenti in processi di revisione e collaborazione.

Nell’ambito tecnico è risaputo che l’AI, con il codice, fa miracoli. D’altronde si tratta di una macchina che studia il linguaggio delle macchine. Oltretutto, per come funzionano questi modelli, potersi addestrare su quantità infinite di codice già scritto, ha permesso a questi modelli di diventare pressoché perfetti in un’attività che per sua natura è già molto più vicina alla macchina che all’uomo. Voglio dire, non si tratta di produrre qualcosa di artistico, ma di codice che verrà poi interpretato da una macchina. Chi più di un’altra macchina potrebbe scriverlo in maniera perfetta?

E così è: oggi si è praticamente avverato il sogno che facevo da bambino: creare programmi e applicazioni non più scrivendo codice, ma parlando in modo naturale con una macchina. È successo, anche se richiede, di nuovo, consapevolezza su quello che viene chiesto e su quello che verrà generato in uscita. Perché poi di mezzo c’è sempre l’interpretazione della macchina e quindi se non sai cosa chiedere, difficilmente ne uscirà qualcosa di buono.

I modelli di intelligenza artificiale, sempre parlando di codice, assolvono benissimo anche a un altro compito: la formazione. Chi volesse imparare a sviluppare, ha delle opportunità incredibili nelle chat AI. Se non ci si lascia ingolosire dalla comodità di aver tutto pronto e fatto in pochi secondi, si può imparare moltissimo e soprattutto in maniera corretta. Il codice generato da questi modelli è un codice pulito, commentato a regola d’arte, scritto nel modo migliore. Se si ha la pazienza di farsi spiegare tutto passo per passo (la macchina, di pazienza, ne ha infinita), si può imparare qualsiasi cosa in pochissimo tempo.

Tutto questo però non vale soltanto nell’ambito dello sviluppo software. Un sondaggio di BCG evidenzia che i cosiddetti “piloti” — lavoratori ad alto grado di autonomia e ottimismo — usano l’AI per stimolare creatività e accelerare progetti, con un impatto positivo riconosciuto anche dai colleghi. Lo stesso rapporto mostra che, se l’AI è introdotta con obiettivi chiari e accompagnata da linee guida, può portare benefici concreti: riduzione dei tempi di stesura dei documenti, miglioramento della qualità delle analisi e, in alcuni casi, crescita della soddisfazione dei dipendenti.

Questi esempi dimostrano che l’AI non è di per sé un acceleratore o un freno: è uno strumento. Se usata con consapevolezza e integrata in contesti ben definiti, diventa un moltiplicatore di valore. Se lasciata senza regole, rischia di trasformarsi in un generatore di rumore. La differenza, ancora una volta, la fanno le persone che la usano.

Il costo nascosto: fiducia e collaborazione

Se i danni del workslop si fermassero al tempo perso, sarebbero già un problema. Ma la vera minaccia si annida altrove: nella fiducia reciproca e nella qualità della collaborazione. Secondo il sondaggio BetterUp Labs citato su Harvard Business Review, più di metà dei lavoratori che ricevono contenuti generati in modo superficiale dall’AI perde fiducia nel collega che li ha inviati. Il 53% si dichiara infastidito, il 38% confuso e il 22% addirittura offeso. Non è solo fastidio: il 42% arriva a considerare quel collega meno affidabile, mentre il 37% lo giudica meno intelligente. Sono percentuali che, in contesti aziendali già fragili, possono tradursi in fratture profonde. Se va bene, in scarsa collaborazione futura, minando la produttività di un intero ufficio o reparto nel lungo periodo.

Il problema, infatti, è che la collaborazione è il cuore stesso del lavoro contemporaneo. In media, un knowledge worker trascorre oltre il 60% del proprio tempo in attività collaborative (riunioni, scambi di documenti, processi condivisi) secondo dati McKinsey. Se questo tempo viene contaminato dal sospetto che il collega stia “barando” con l’AI o scaricando lavoro sugli altri, l’effetto non è solo inefficienza: è un’erosione lenta del capitale sociale delle organizzazioni.

Molte ricerche sul cosiddetto competence penalty mostrano che persino quando l’AI produce codice valido, i colleghi tendono a percepire chi la usa come meno competente. Il paradosso è che lo stigma colpisce in modo sproporzionato - indovinate chi? - le donne, accentuando disuguaglianze già esistenti.

Non è difficile immaginare lo scenario: un documento “workslop” non solo ruba due ore al collega che deve correggerlo, ma lascia dietro di sé un segno invisibile. La prossima volta che quel collega riceverà una mail o un report, partirà con un pregiudizio negativo: «vediamo che pasticcio ha combinato stavolta». Questo atteggiamento mina la collaborazione, frena la voglia di condividere informazioni e riduce la disponibilità a lavorare insieme. Lo confermano i dati: un terzo dei dipendenti (32%) dichiara di non voler più collaborare con chi ha inviato workslop. E il 34% afferma di aver segnalato questi episodi a manager o colleghi, alimentando dinamiche di sfiducia e micro-conflitti interni.

In un contesto simile, il rischio non è solo economico, ma culturale. La promessa dell’AI come strumento di cooperazione e crescita condivisa si trasforma nel suo opposto: un generatore di frizioni, di piccole ingiustizie e di sfiducia. Ed è proprio qui che si decide il successo o il fallimento della sua adozione. Perché senza collaborazione, l’AI non potrà mai esprimere il suo potenziale trasformativo: resterà una stampella che divide invece di un ponte che unisce.

La Generazione IA: dalla scrivania all’aula

Quello che accade nelle aziende ha un riflesso immediato anche nel mondo della scuola. In Italia, secondo un’indagine condotta da Tortuga con Yellow Tech e raccontata da Domani del 22 settembre, l’86% degli studenti utilizza già strumenti di AI generativa come ChatGPT, Gemini o Copilot per prepararsi agli esami, scrivere testi o risolvere esercizi. Una diffusione rapidissima, molto più veloce di quanto avvenne per il computer o per Internet: se allora servirono anni per trasformarsi in strumenti di massa, qui la curva è stata verticale, tanto da battezzare i ragazzi di oggi come Generazione Ia.

Merito di questa velocità è anche il fatto che oggi ognuno di loro ha in tasca un computer che gli permette di utilizzare questi strumenti nel momento stesso in cui vengono rilasciati. E il mondo adulto come reagisce davanti a questo fenomeno nuovo e tutto da capire, gestire, analizzare, indirizzare? Vietandolo, chiaramente. Ma lasciamo le polemiche ai Pensieri Franchi.

Il problema è che i docenti restano indietro. Solo una minoranza (11%) usa regolarmente l’AI in modo estensivo, e quasi sempre per compiti amministrativi più che didattici. Così si apre un divario: studenti che sperimentano e si affidano quotidianamente agli algoritmi, insegnanti che li guardano con sospetto o li ignorano del tutto. Questo scarto genera un cortocircuito educativo: se un elaborato nasce con l’aiuto dell’AI, deve avere lo stesso voto di uno scritto in autonomia? E come si valuta la reale comprensione quando dietro il compito ci potrebbe essere un chatbot?

La questione è culturale prima ancora che tecnica. Molti docenti temono che l’AI riduca la capacità critica degli studenti, mentre le ricerche mostrano che, usata bene, potrebbe alleggerire il carico di lavoro amministrativo di tre ore a settimana e lasciare più spazio all’interazione con la classe. Un’opportunità che in Italia rischia di restare sulla carta, sprecata, come spesso avviene anche nelle aziende: troppo spesso l’AI viene vista solo come una scorciatoia, non come un’occasione per ripensare i processi. Insalata Mista, già in passato, si è interrogata sull’uso dell’AI per studiare, per esempio.

Ed è qui che il parallelo con il workslop diventa evidente. Così come nei luoghi di lavoro un documento generato male può minare la fiducia tra colleghi, a scuola un uso inconsapevole dell’AI rischia di incrinare il patto tra studenti e insegnanti. La differenza la farà, ancora una volta, la capacità di guidare questa tecnologia: introdurla in modo consapevole, insegnarne i limiti, usarla per personalizzare la didattica invece che per sostituire la fatica cognitiva. Perché senza un quadro chiaro, anche nelle aule rischiamo di produrre montagne di output scintillanti ma vuoti — workslop educativi, li definirei — che lasciano indietro chi avrebbe più bisogno di imparare davvero.

Non serve demonizzare l’AI né illudersi che basti un divieto per tenere lontani i suoi rischi. Lo strumento in sé non ha colpe: siamo noi a decidere come usarlo, e soprattutto come insegnarne l’uso. Vietarlo o far finta che non esista significa lasciare spazio al suo lato peggiore, quello che prospera nella superficialità e nell’assenza di regole. Serve invece conoscerlo, capirne i limiti e le potenzialità, accompagnare le persone a un utilizzo consapevole. Solo così l’AI può diventare davvero un alleato, e non l’ennesimo capro espiatorio tecnologico.

Perché, in fondo, l’AI non è né buona né cattiva: dipende tutto da chi la maneggia.

Se sei arrivato fino a qui, innanzitutto ti ringrazio.

Non ci siamo presentati: mi chiamo Franco Aquini e da anni scrivo di tecnologia e lavoro nel marketing e nella comunicazione.

Se hai apprezzato la newsletter Insalata Mista ti chiedo un favore: lascia un commento, una recensione, condividi la newsletter e più in generale parlane. Per me sarà la più grande ricompensa, oltre al fatto di sapere che hai gradito quello che ho scritto.

Franco Aquini

Che bella parola che mi hai insegnato Franco, workslop! Racchiude perfettamente la sciatteria umana sul luogo di lavoro.

Bell'articolo, come sempre.

Per coerenza dovresti aver usato l'IA per scrivere questo articolo 😄

Bel riassunto, come sempre il risultato dell'uso di uno strumento va in base a chi l'adopera, demonizzarla e non approfittarne sarebbe sciocco, però va imparata ad usare.