Dai videogiochi all’Intelligenza Artificiale: l'intuizione di NVIDIA e l'evoluzione delle GPU

Ci credereste che quello che oggi chiamiamo intelligenza artificiale è nato dai videogiochi? Eppure è così: la richiesta di potenza di calcolo ha portato Nvidia a sfruttare le GPU per le reti neurali.

Lo ammetto, c’è una sottile soddisfazione nel constatare una cosa che potrà sembrare banale soltanto al ristretto popolo dei videogiocatori, ristretto se confrontato al totale della popolazione, ovviamente: la più grande rivoluzione dei nostri tempi, che cambierà la nostra vita e il mondo per sempre traformandola in qualcosa di profondamente diverso, ha avuto origine dai videogiochi.

Si, proprio quella cosa che viene derisa e sbeffeggiata ancora da un sacco di adulti saccentelli, ha posto le basi per la più grande rivoluzione dei nostri tempi, superiore per impatto sulla società, sulle persone di tutto il mondo e sulle vite di queste persone persino all’invenzione dei computer e di internet.

Le chat che stiamo cominciando a conoscere e i modelli che ci sono dietro, che a livello più alto permettono già oggi di fare in poco tempo quello che a scienziati e ingegneri richiederebbe decenni, poggiano le basi su processori molto potenti e specializzati, a volerla fare semplice, nel calcolo parallelo. Sono le GPU (Graphics Processing Unit) di Nvidia, prima azienda fra tutti, ad aver permesso la realizzazione di grandi datacenter realizzati per addestrare i modelli di Meta, OpenAI, Google (anche se quest’ultima, lo vedremo, si è realizzata il primo processore) e molte altre aziende. È grazie alla potenza di calcolo parallelo delle GPU di Nvidia se si è arrivati ad avere la potenza necessaria per poter utilizzare oggi, con una naturalezza incredibile, ChatGPT o DeepSeek.

Da dove nasce Nvidia?

Nvidia nasce nel 1993 in California da Jen-Hsun Huang, Chris Malachowsky e Curtis Priem. Nacque con lo scopo di produrre processori grafici adatti a gestire la grafica 3D. I primi prodotti, qualcuno tra voi li ricorderà, furono le schede grafiche Riva TNT, tra le prime a fondere in un’unica scheda le funzioni di accelerazione 2D e 3D insieme. Prima di allora, infatti, i computer avevano bisogno di una scheda per il 2D e un acceleratore per il 3D. Erano gli anni in cui a una Matrox, azienda leader per l’elaborazione della grafica 2D, si affiancava fisicamente all’interno di un computer una scheda come la VooDoo 3Dfx, che accelerava il calcolo dei poligoni e aggiungeva degli effetti grafici sorprendenti, come il motion blur, che “spalmava” i pixel con un effetto di omogeneità incredibile. Oppure l’antialiasing, che eliminava la seghettatura provocata dalla bassa risoluzione.

Dopo TNT, nel 1999 arrivò la prima GeForce, ovvero la GeForce 256, primo modello di quella famiglia che poi arriverà ai giorni nostri, incrementando anno dopo anno la potenza di calcolo in maniera incredibile

Cos’è CUDA?

Lo sviluppo delle GPU grafiche di Nvidia procedette in modo pacifico per diversi anni, migliorando non solo la potenza di calcolo 3D, ma anche gli effetti applicabili alle immagini, rendendo i videogiochi sempre più fluidi e belli da vedere. Da un certo anno in poi, però, nell’elenco di caratteristiche e librerie supportate comparse un nome nuovo.

Stiamo parlando della serie GeForce 8 (qualcuno di voi ricorderà la GeForce 8800 GS, GT o GTS). Queste schede grafiche supportavano le librerie DirectX 10 di Microsoft, OpenGL 3.3 e, per la prima volta, CUDA.

CUDA è un acronimo che sta per Compute Unified Device Architecture ed è la prima piattaforma di Nvidia studiata per il calcolo parallelo. È in sostanza la base su cui poggia quello che oggi ha permesso a queste GPU di essere perfette per lo sviluppo delle reti neurali e quindi delle intelligenze artificiali. CUDA diede accesso agli sviluppatori ad un set di istruzioni native per il calcolo parallelo, trasformando le GPU in qualcosa di perfetto per i videogiochi, ma anche qualcos’altro che vedremo nascere di lì a poco.

Dalla grafica all’intelligenza artificiale

Il salto viene compiuto nel 2012, anno in cui succede qualcosa di pionieristico. I ricercatori dell’Università di Toronto utilizzano infatti la GPU NVIDIA per addestrare AlexNet, una rete neurale convoluzionale che ottiene risultati rivoluzionari nel riconoscimento di immagini. Questo successo evidenzierà come le GPU possano accelerare significativamente i processi di deep learning, portando a una crescente adozione delle GPU Nvidia nei centri di ricerca e nelle aziende tecnologiche.

Leggo e riporto da Wikipedia:”AlexNet rappresentò un significativo avanzamento nel riconoscimento automatico delle immagini. Nella ImageNet Large Scale Visual Recognition Challenge del 2012 AlexNet ottenne un errore top-5 del 15.3%, oltre 10.8 punti percentuali in meno del secondo classificato. La profondità del modello risultò essenziale per la qualità dei risultati, e il problema dell'elevato costo computazionale venne aggirato eseguendo l'addestramento del modello su due GPU in parallelo”. Pensate, soltanto due GPU in parallelo.

“La descrizione e i risultati di AlexNet furono pubblicati nel 2012 in uno degli articoli di ricerca più influenti nella storia della visione artificiale, citato in oltre 130 000 pubblicazioni fino al 2023, aprendo la strada all'uso estensivo del deep learning nella visione artificiale”.

Ci siamo, i due dottorandi, Alex Krizhevsky e Ilya Sutskever, sotto la supervisione di Geoffrey Hinton, tolgono il velo da quella che sarà una delle loro più grandi intuizioni. Nessuno potrà più rimanere indifferente davanti al fatto che con l’uso di due sole GPU i due ricercatori siano riusciti a ottenere risultati con un livello così elevato di precisione.

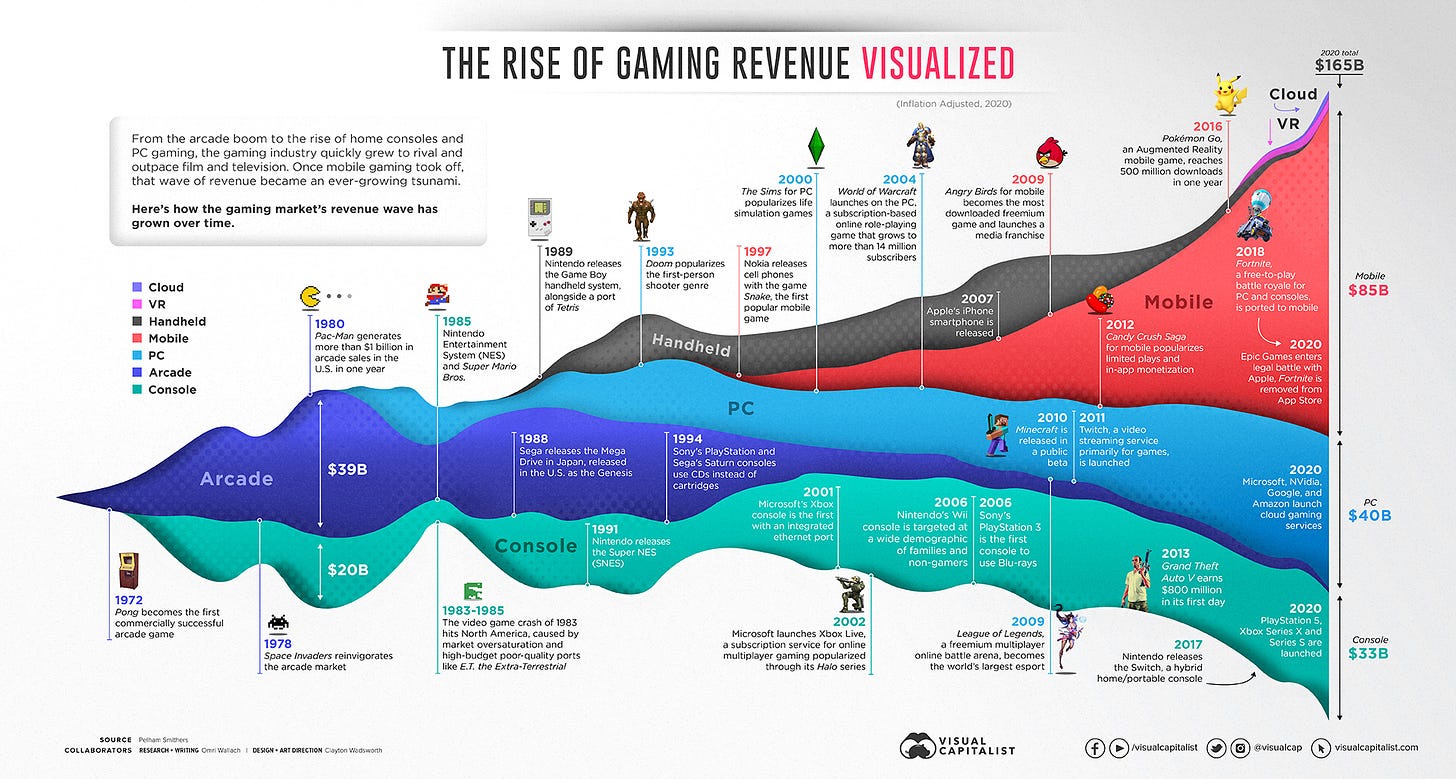

Da lì in avanti, un settore ha influenzato l’altro. La grande domanda di performance in ambito videoludico - un mercato che, ricordiamocelo, nei primi anni 2000 valeva qualche decina di miliardi e oggi ne vale 330, con la previsione di raggiungere i 500 miliardi nel 2027 - spinge Nvidia a sviluppare GPU sempre più potenti e a loro volta le GPU, pur non rappresentando ancora un introito interessante per l’azienda sotto questo tipo di profilo, vengono sfruttate per costruire modelli di apprendimento sempre più complessi.

Nel 2016 capita un’altra cosa fondamentale nella storia del calcolo e dello sviluppo dell’intelligenza artificiale. Arriva AlphaGO, ovvero un programma sviluppato da Google DeepMind per giocare a un gioco da tavolo millenario nato in Cina e riconosciuto come tra i più complessi in assoluto, il Go.

AlphaGo fu in grado di battere Lee Sedol (all’epoca secondo al mondo in Go) grazie all’uso combinato di CPU, GPU e TPU. Su quanti di questi specifici chip vennero impiegati non si conoscono i numeri precisi. C’è chi sostiene che vennero utilizzati 1,202 CPU e 176 GPU, l’Economist invece parlò di 1,920 CPU e 280 GPU. In ogni caso, si parlava di qualche centinaio di GPU, ben lontani dagli enormi datacenter utilizzati oggi per allenare gli attuali modelli di intelligenza artificiale. Oltre a questi, però, Google dichiarò di aver utilizzato 4 unità Tensor.

Le unità Tensor, o TPU, sono circuiti integrati specifici per l'applicazione dell'acceleratore AI (ASIC) sviluppati da Google per l'apprendimento automatico della rete neurale, utilizzando il software TensorFlow di Google stessa. Google ha iniziato a utilizzare le TPU internamente nel 2015 e nel 2018 li ha resi disponibili per l'uso di terze parti, sia come parte della sua infrastruttura cloud che offrendo una versione più piccola del chip in vendita.

La trasformazione è compiuta: da potenza grafica a potenza di calcolo per l’IA

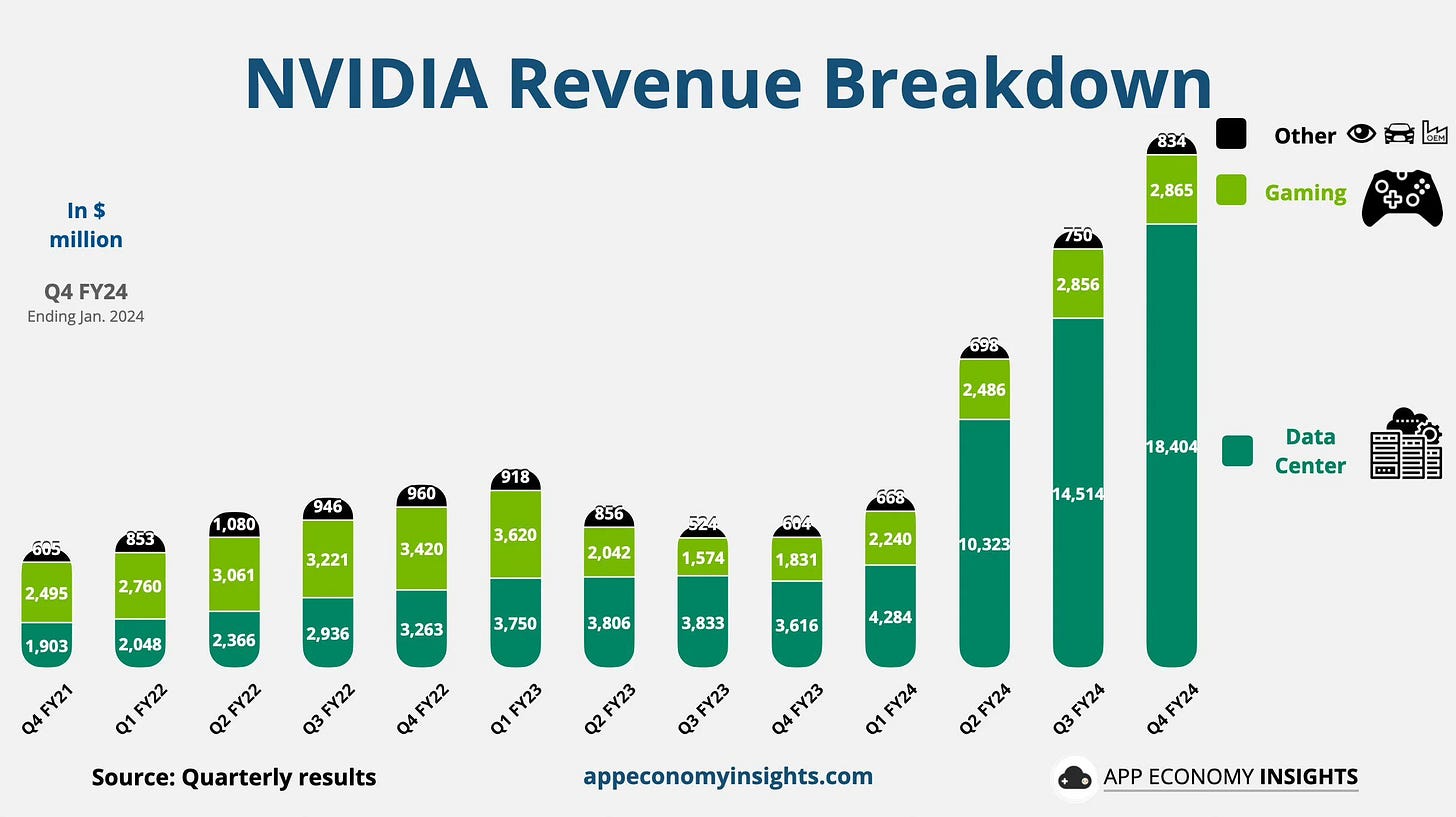

Da allora, Nvidia ha concentrato gran parte dei suoi sforzi in quello che aveva intuito essere il futuro, lo sviluppo di potenza di calcolo per le reti neurali. A dirlo sono i numeri: Nvidia oggi è la seconda azienda al mondo per capitalizzazione e il suo fatturato è schizzato a partire dal secondo trimestre dello scorso anno.

A cambiare in modo radicale è però il mix dei settori dai quali deriva questo fatturato. Se ancora a fine 2021 la maggior parte del fatturato (2,5 miliardi) derivava dall’ambito dei videogiochi (contro 1,9 miliardi dai data center), a fine 2024 dai videogiochi arrivano 2,8 miliardi (comunque in crescita), ma i data center passano a 18 miliardi in un solo trimestre, un incremento dell’847%. La trasformazione è completa, Nvidia è ormai l’azienda più importante al mondo nell’ambito del calcolo per l’IA, con tutto quello che ne consegue.

Le GPU sono diventate essenziali per il calcolo distribuito e per le grandi infrastrutture di deep learning, come i supercomputer utilizzati da Meta, OpenAI e altre aziende tecnologiche. Nel 2023, NVIDIA ha lanciato le GPU della serie H100, progettate specificamente per accelerare i modelli di intelligenza artificiale generativa. Questa nuova generazione di schede grafiche offre prestazioni superiori di oltre 10 volte rispetto ai modelli precedenti, consentendo di addestrare reti neurali in tempi record.

Nvidia, tuttavia, non è da sola in questa corsa. La rivale di sempre, la californiana AMD fondata nel 1969, è un rivale anche nel settore del calcolo per questo genere di applicazioni con la sua linea di GPU Instinct. Intel ha recentemente introdotto le GPU della serie Ponte Vecchio, progettate per competere con NVIDIA nei data center e nell’intelligenza artificiale.

Poi c’è Google, l’abbiamo vista prima, che con le sue TPU offre dei chip progettati per essere più efficienti delle GPU tradizionali in specifiche applicazioni di intelligenza artificiale. E infine ci sono aziende come Graphcore e Cerebras, che stanno sviluppando processori specializzati che offrono alternative alle GPU tradizionali per l'addestramento delle reti neurali.

In ogni modo, tutto è nato da lì, dal videogioco e dalla sua forza di spingere un’azienda a creare dei processori sempre più potenti e a scoprire un’applicazione che si è rivelata fondamentale anche per altro. E da lì, quasi casualmente, siamo arrivati ai giorni nostri, con modelli di linguaggio che si stanno rincorrendo a una velocità pazzesca. E tutto quello che stanno permettendo questi processori, è tutto tranne che un gioco.

» PENSIERI FRANCHI: Quanto siamo disposti a pagare?

→ “Pensieri Franchi” è il mio editoriale. O meglio, i miei pensieri in libertà.

Qualche giorno fa, una conoscente mi ha chiesto il solito favore che si chiede a quelli come me, quelli che “ne sanno” di computer. Mi ha chiamato dicendomi che le è stato regalato un lettore di eBook e dunque voleva capire come scaricare libri gratis.

Già, perché se è digitale è gratis no?

Sembra assurdo dover ancora confrontarsi con questo luogo comune, ma in realtà mi ci scontro più spesso di quanto sarebbe lecito pensare. Le persone, quantomeno quelle comuni, tendono ancora ad assegnare un valore a qualcosa quando quel qualcosa è tangibile, quando si tocca con mano. Così se un libro è fatto di carta e se te lo tiri su un piede fa male, allora può avere un suo corrispettivo in denaro, mentre se non puoi toccarlo allora no, bisogna trovare semplicemente il modo di trovarlo sulla rete.

La cosa che fa più specie è che non viviamo più nell’epoca in cui il digitale si affacciava nelle nostre vite come una cosa nuova e da nerd. No, oggi la pubblica amministrazione è quasi completamente digitalizzata (bene o male che sia), il denaro è diventato per lo più intangibile, le foto sono solo sui nostri dispositivi digitali (male!) e gran parte dei documenti che maneggiamo esistono soltanto come un agglomerato di bit. Le cose digitali hanno un valore concreto già da un bel po’.

Evidentemente però c’è ancora una cosa specifica che in digitale non ha valore: l’opera intellettuale. Già, perché se compri un pezzo di pane con la carta di credito, i soldi non li vedi, ma il pezzo di pane si. Invece quando acquisti l’opera dell’intelletto di qualcuno non vedi niente e pertanto qualcuno vorrebbe poter pagare soltanto se in mano ti ci finisce qualcosa. Un libro lo senti in mano, hai voglia, soprattutto se è un libro di tante pagine, che pesa un sacco, quello può costare anche 20 euro. Un libro di poche pagine invece potrà costare al massimo 8/10 euro. Se è digitale… beh, viene da sé che deve essere gratis.

E così, questa mia conoscente, che pure non è una persona che è appena scesa dalla montagna e che si ciba di carne cruda, mi ha tranquillamente chiesto se potevo insegnarle come si entra in questi gruppi Telegram dove si scaricano tutti i libri gratis. Io, timidamente, ho cercato di portarla a capire in autonomia che se esistono dei posti dove si trova gratis quello che gratis normalmente non è, forse c’è qualcosa che non va, no? Lasciamo stare poi che quei canali Telegram sono il corrispettivo nel mondo “emerso” del dark web e che se non stai attento ti trovi a casa un killer lituano che ti chiede chi deve far fuori, ma quantomeno farsi delle domande, no?

No, alla fine gliel’ho dovuto dire chiaramente:”guarda che non è legale”. E lei mi ha guardato con uno sguardo stupido. Non perché improvvisamente si è resa conto che quello che pensava fosse perfettamente legale in realtà non lo era, bensì perché le sembrava strano che considerassi illegale il suo banale consumo di qualche libro piratato. Già, di nuovo la quantità. Quand’è che si diventa complici del mondo della pirateria? Quando se ne scaricano 10? 100? 1000? E vale anche per il digitale il discorso delle pagine oppure quello è un fatto che riguarda soltanto il mondo fisico?

Alla luce di questi fatti, che probabilmente stupiscono soltanto me, mi stupisco assai meno se poi mi accorgo che dalle nostre parti quasi nessuno è disponibile a pagare un corrispettivo in denaro per prodotti editoriali come questa newsletter. Attenzione, non ho mai chiesto soldi e non è in programma di farlo, ma molti progetti editoriali a me cari faticano a trovare una qualche forma di sostegno con abbonamenti e donazioni varie. Chi decide di spendere qualche soldo lo fa in amicizia. A livelli più importanti si raccolgono invece soldi anche in quantità cospicue, ma si tratta perlopiù di volti noti, che generano delle community di fans e pertanto si tratta di pagamenti dovuti al sostegno del proprio beniamino, piuttosto che a sostegno dell’opera della quale si sta usufruendo.

Tanti anni fa, prima che Cruciani trasformasse la sua trasmissione in un caravan serraglio di mostri, nostalgici del ventennio e pornoattrici, ero decisamente dipendente da La Zanzara, trasmissione di Radio 24 super popolare condotta appunto da Cruciani e Parenzo. All’epoca il fenomeno dei podcast era molto meno diffuso di oggi e a farmi compagnia nelle mie ore di guida quotidiana c’erano quasi soltanto loro. Un giorno mi chiesi: è se domani dovesse finire tutto? Quanto sarei disposto a pagare per sostenere la trasmissione e fare in modo che non chiuda? 5 euro al mese? 10?

Mi resi conto improvvisamente che per me era una cosa importante, faceva parte della mia routine, mi faceva compagnia in macchina e mi dava anche del valore in termini di informazione e di ragionamento (si, c’è stato un tempo in cui La Zanzara era anche questo, incredibile eh?).

Forse è un ragionamento che dovremmo fare un po’ tutti quando approcciamo le cose intangibili e in particolar modo quelle che sono opera d’intelletto: se un domani finisse tutto, se il mondo dell’editoria dovesse improvvisamente crollare sotto i colpi di un mercato delle copie vendute che è ormai ai minimi termini e dello strozzinaggio delle piattaforme digitali, cosa ci perderemmo?

Perché se c’è gente che scarica i libri illegalmente significa che una certa domanda allora c’è. E allora, se domani finisse tutto, ci mancherebbe qualcosa no? Non parlo di Insalata Mista, per carità, senza questa newsletter vivrebbero tutti benissimo lo stesso, ma se a sparire fossero le librerie, la stampa, l’informazione intera? Quanto può valere preservare l’editoria? Quanto siamo disposti e metterci per tenere in piedi un settore che se la sta passando malino?

Lo stesso vale per qualsiasi forma di opera di intelletto: la musica, l’arte, la poesia. L’epoca del mecenatismo è finita da un bel po’ e chi produce opere intangibili vive di denaro come chiunque altro. C’è bisogno dei vostri soldi, in altre parole, pochi o tanti che siano. Non è solo una questione etica o di lotta alla pirateria, si tratta di tenere a galla un intero settore che sta affogando e che ci guarda implorandoci con tutto il corpo sotto l’acqua e la sola mano che esce fuori, in un ultimo gesto di supplica.

Ah già, forse la metafora dell’uomo in mare non funziona più così bene per far leva sull’istinto umano del soccorso. Forse è meglio fare un altro genere di esempi e forse, anche questo fatto, riguarda l’informazione e l’editoria.

Franco A.

» COSE MOLTO UTILInk

» SFAMA LA FOMO!

Cos’è la F.O.M.O.?1

Protoclone: l’androide iperrealistico che inquieta con i suoi movimenti artificiali

Clone Robotics ha presentato Protoclone V1, un androide bipede con scheletro e muscoli sintetici, progettato per replicare fedelmente il corpo umano. Il video di presentazione, con movimenti meccanici e un’atmosfera cupa, ha suscitato reazioni contrastanti. L’androide utilizza muscoli artificiali (Myofiber) e un sistema nervoso avanzato con visione artificiale e sensori propriocettivi. Attualmente basato su attuatori pneumatici, in futuro passerà a un sistema idraulico. Clone Robotics promette un prodotto rivoluzionario e preordinabile nel 2025, ma molte delle sue capacità restano ancora da dimostrare.

Fonte: DDay.it

Majorana 1: Il chip quantistico rivoluzionario di Microsoft

Microsoft ha presentato Majorana 1, il primo chip quantistico che utilizza qubit topologici basati sulle quasi-particelle di Majorana, garantendo stabilità intrinseca e dimensioni contenute – grande quanto il palmo di una mano. Grazie a una struttura a forma di H, ogni qubit è formato da quattro particelle, eliminando la necessità di sistemi complessi di correzione degli errori. Il chip, con 8 qubit attuali e scalabile fino a 1 milione, promette di rivoluzionare il calcolo quantistico integrandosi in sistemi ibridi come acceleratore quantistico per applicazioni in diversi settori, dalla progettazione di nuovi materiali allo sviluppo di soluzioni innovative per la scienza e l’industria.

Se volete saperne di più di computer quantistici, c’è una puntata di Insalata Mista sull’argomento che potete trovare qui.

Fonte: DDay.it

Apple lancia iPhone 16e: il primo con modem 5G C1 sviluppato in casa

Avevamo parlato di iPhone SE4 e invece Apple ha annunciato a sorpresa iPhone 16e, un nuovo modello della gamma iPhone 16, che si distingue per il debutto del modem 5G C1, sviluppato internamente per migliorare efficienza energetica e autonomia. Dotato di chip A18 e 8 GB di RAM, è il dispositivo Apple più economico compatibile con Apple Intelligence. Il design rinuncia alla Dynamic Island, mantenendo il notch e una singola fotocamera da 48 MP. Disponibile in bianco e nero, parte da 729 euro, con preordini dal 21 febbraio e lancio il 28 febbraio.

Fonte: DDay.it

Mercedes testa su strada le batterie allo stato solido: autonomia fino a 1000 km

Mercedes ha avviato i test su strada delle batterie allo stato solido sviluppate da Factorial Energy, installandole su un prototipo di EQS con pacco batteria modificato. Le nuove celle, con una densità energetica di 390 Wh/kg, offrono fino al 25% di autonomia in più, raggiungendo potenzialmente 1000 km con una carica. La tecnologia, ancora in fase di sviluppo, è prevista sul mercato entro fine decennio, con applicazione iniziale nei modelli di fascia alta.

Fonte: DMove.it

Stellantis lancia STLA AutoDrive: guida autonoma di livello 3 fino a 60 km/h

Stellantis ha presentato STLA AutoDrive 1.0, il suo primo sistema di guida autonoma sviluppato internamente, capace di livello 3 SAE fino a 60 km/h. Il sistema consente di guidare senza mani e senza dover guardare la strada, ideale per il traffico urbano e situazioni di stop-and-go. A velocità superiori, invece, offre supporto di livello 2 e 2+, richiedendo l’attenzione del conducente. Stellantis prevede aggiornamenti futuri per estendere la guida autonoma fino a 95 km/h e introdurre nuove funzionalità.

Fonte: DMove.it

Se sei arrivato fino a qui, innanzitutto ti ringrazio.

Non ci siamo presentati: mi chiamo Franco Aquini e da anni scrivo di tecnologia e lavoro nel marketing e nella comunicazione.

Se hai apprezzato la newsletter Insalata Mista ti chiedo un favore: lascia un commento, una recensione, condividi la newsletter e più in generale parlane. Per me sarà la più grande ricompensa, oltre al fatto di sapere che hai gradito quello che ho scritto.

Franco Aquini

La F.O.M.O., un acronimo che sta per Fear Of Missing Out, è la deriva moderna del tam tam dei social network unita all’enorme disponibilità di strumenti di informazione e di intrattenimento. In pratica, è la paura di perdersi qualcosa e di non essere sempre al passo con i tempi. Con questa rubrica rispondiamo a queste paure, riassumendo in breve le notizie più significative della settimana, pescate dal mondo della tecnologia, dell’entertainment e del lifestyle.

Gran bell'approfondimento questa settimana, ti faccio davvero i complimenti per come hai esposto con chiarezza un tema per niente semplice. Venticinque anni fa bramavo le GeForce leggendone le performance sulle riviste di videogiochi, ma non avevo il coraggio di chiedere a mio padre di aprire il portafogli: chi avrebbe mai immaginato che un giorno Nvidia avrebbe dominato il mondo intero?

Due parole anche sull'editoriale. Hai toccato un tema su cui rifletto spesso, soprattutto negli ultimi tempi. Proprio il mese scorso sulla mia newsletter dicevo che uno dei grandi inganni del web è stato convincerci che tutto sia gratis. Io solo di recente ho cominciato a pagare per fruire online di alcune testate di informazione, ma spero che sempre più persone adottino questa forma mentis (anche se mi rendo conto che non è facile, e che per alcuni è anche materialmente non fattibile).

ho ascoltato solo adesso i pensieri franchi e devo dire che l'utente apprezza la semplicità

ai tempi dell'amiga compravamo i giochi piratati perchè c'era il catalogo di tutto quanto e costava poco

ai tempi di napster scaricavamo gli mp3 perchè era semplice ed era gratis

ai tempi dei torrent scaricavamo i film perchè era semplice ed era gratis

oggi però abbiamo netflix e spotify che costano poco ma non sono gratis, e li si usa comunque

io ci vedo appunto da parte dell'utente la facilità di accesso ed il costo accessibile, e da parte dell'industria la "mondezza" che viene prodotta e il guadagno risibile dei musicisti/attori (quelli che non sono le star, ma nella musica anche le star guadagnano dai tour)

quello che mi fa "strano" è che di fatto ok utente ruba (ed è verissimo) scaricando i libri gratis, però ecco il mercato digitale, che non ha supporto fisico, non ha distribuzione, non ha intermediari, costa mediamente troppo rispetto al supporto fisico. prendi un videogioco, non dovrebbe costare la metà della edizione fisica?